本篇目录:

Solr的更新很慢问题,怎么解决

1、应该是先按找 数据库的索引查询出一少部分 几百或几千行数据在分页,这样才有意义。

2、用来编写程序,对于编程语言,各有各和看法,我认为编程语言没有高低之分,水平才有高低之分,delphi的比其他语言更注重对数据库的操作。

3、首先淘宝的商品数据以及图片不只是存放在数据库里的,而是分布式数据库和全文检索引擎同步,比如Whoosh,比如solr。

4、改回缺省的内存配置,导入速度仍然慢。 重启Linux,用10G的内存配置,再导入,5030万条记录,用时92分,约9112条/秒,说明导入速度和内存配置没有大差别 在10G配置的情况下,检索速度也差别不大。

如何在solr配置文件里添加新的搜索字段

正排表结构如图1所示,这种组织方法在建立索引的时候结构比较简单,建立比较方便且易于维护;因为索引是基于文档建立的,若是有新的文档加入,直接为该文档建立一个新的索引块,挂接在原来索引文件的后面。

Solr 的 geofilt 过滤器可以实现 LBS 检索,但要在 schema.xml 配置中将需检索字段的字段类型设置为 solr.LatLonType 类型。

启动本机的mysql数据库 我新建test数据库,并在其中新建test表,表有两个字段,ID与Val。ID表示文档编号,Val表示文档内容,这是一个最简单的数据源。

.首先,注意路径是否为:无法为corecollection1加载conf:载入solrconfigfrom/home/WWW/solr/solr/home/collection1/conf/solrconfig时出错。XML。

.首先,注意路径是否为:无法加载confforcorecollection1:载入solrconfigfrom/home/WWW/solr/solr/home/collection1/conf/solrconfig时出错。XML。

求助:solr如何通过指定条件修改数据

在commit完成后,是否开启新的searcher,以便能够搜索到新的数据。开启新searcher时,过期旧searcher的cache(如filterCache, queryResultCache等),对新searcher进行Autowarming操作。

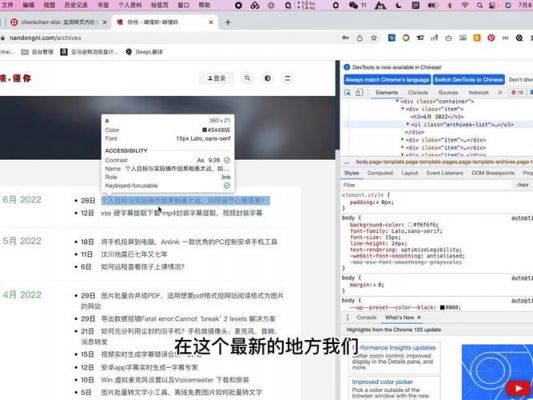

查询字符串 q 由以下元素项组成,字段条件形如 fieldName:value 格式:以上元素项的默认值由 solrconfig.xml 配置文件定义。通常查询时设置 q=*:* ,然后通过 fq 过滤条件来完成查询,通过缓存提高查询性能。

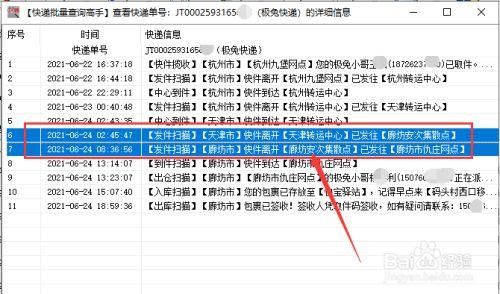

可以通过定时任务实现solr与数据库数据的的一致性、比如每天夜里某个时间点、对数据进行更新同步。

Solr——commit

soft commit是solr 0中提供的新功能,soft commit是实现Solr的near real time search(NRT)功能的基础 soft commit保证数据的可见性,无论此时数据是否保存在索引库中。

solr索引过程分析 分布式的索引起始就是在每个sharding中建立索引,在sharding中的索引过程和单节点的情况是一致的。

在eclipse中部署solr的web工程的方法:首先在eclipse(散仙这里是2)里,新建一个动态的Web工程。

本文是延续 Solr的使用 系列,前一篇文章已经讲了 Solr 的部署和数据推送,这里主要以示例方式讲述 Solr 的常见查询语法,同时介绍如何使用 PHP 语言的客户端 solarium 同 Solr 集群进行数据交互。

如何保证solr跟数据库的数据一致性

要使用封锁机制来保证数据的一致性,通常涉及以下步骤: 选择合适的封锁类型:封锁机制有多种类型,包括行级封锁、表级封锁、和事务封锁。行级封锁是最细粒度的封锁,它可以阻止多个事务同时对同一行数据进行修改。

保证数据库一致性是指当事务完成时,必须使所有数据都具有一致的状态。在关系型数据库中,所有的规则必须应用到事务的修改上,以便维护所有数据的完整性。

使用复制技术,用户可以将一份数据发布到多台服务器上,从而使不同的服务器用户都可以在权限的许可的范围内共享这份数据。复制技术可以确保分布在不同地点的数据自动同步更新,从而保证数据的一致性。

为了解决这个问题,有以下几种方案: 更新数据库 + 更新缓存 更新数据库 + 删除缓存 加「分布锁」第一种方案可以保证数据的一致性,但是在某些场景下可能会导致性能问题。

数据更改比较少的系统中。 快照复制与其他复制相比最主要的缺陷就是数据库中的数据无法及时同发布服务器一致。为此如果发布服务器中的内容很少更改的话,显然此时采用快照复制是比较合理的。

面试题剖析一般来说,如果允许缓存可以稍微的跟数据库偶尔有不一致的情况,也就是说如果你的系统不是严格要求“缓存+数据库” 必须保持一致性的话,最好不要做这个方案,即:读请求和写请求串行化,串到一个内存队列里去。

到此,以上就是小编对于solr批量删除的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏