本篇目录:

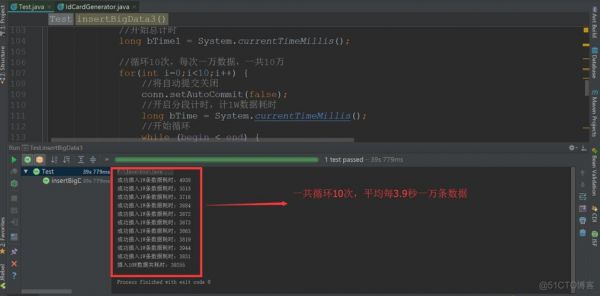

richsinkfunction如何批量提交到数据库

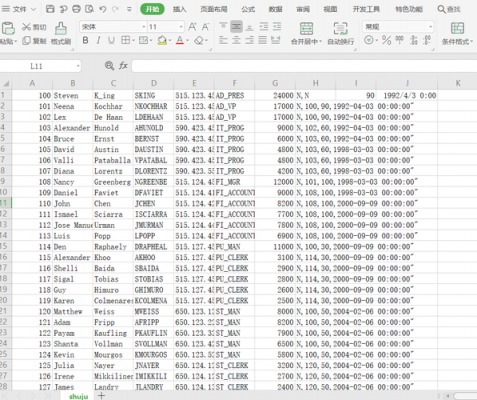

首先在Spark应用程序中使用DataFrameAPI或SparkSQL对数据进行处理。其次使用DataFrame的write方法或SparkSQL的INSERTINTO语句将处理后的数据写入数据库。然后使用的数据库系统,需要进行适当的配置。

一次sparksql问题排查记录

一般情况下,Spark SQL在进行WhereIn子查询时,如果使用默认情况下的配置参数,则可能会由于网络抖动或数据倾斜等问题导致查询出错。解决该问题的方法有两种:采用批量处理的方式。

使用Spark处理日志文件的优点在于,可以利用Spark的分布式计算能力,对大量的日志文件进行快速的处理。例如,可以使用Spark的MapReduce算法快速统计日志文件中各种类型的记录数量,或者使用Spark SQL快速查询日志文件中的特定信息。

弥补关系数据库在大数据时代的不足:随着数据量的增长,传统的关系数据库在处理大数据时遇到了性能瓶颈,SparkSQL作为一种基于Spark的大数据处理工具,能够高效地处理大规模数据,弥补了关系数据库的不足。

redis多key:value,zookeeper目录数结构的key:value都不直观,通常也需要另外实现外部存储和redis和zookeeper的数据做关系,例如sql。sparksql的支持较晚,初期streaming无法使用sparksql而是应用jdbc,导致延用惯性。

flinksql字段只看顺序

是的。flinksql可以通过create语句控制字段个数和顺序,决定后面insertinto的select语句中的字段顺序受影响,所以insertinto的select只能跟create定义的顺序一样,不能改别名。

在SQL中,使用GROUP BY 分组,SELECT 查询中的列必须在GROUP BY 中出现,不然会报错但,GROUP BY 后面的列,不一定要在前面查询中出现。INNER JOIN 可以和GROUP BY 一起使用。

其中字段定义时还可以声明表主键,声明语法为PARIMARY KEY(myColumn1,...) NOT ENFORCED, 这里的not enforced表示flinksql不会对主键做强制的唯一性约束、非空约束,而且目前flinksql中只支持这种类型的主键。

到此,以上就是小编对于spark批量写入mysql的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏