本篇目录:

如何每日增量加载数据到Hive分区表

1、讲MR输出数据到hive表的location分区目录,然后通过Sql添加分区即可。ALTERTABLEtable_nameADDPARTITION(partCol=value1)locationlocation_path换成自己的表,分区字段和path。

2、使用Flume实时导入数据:如果需要实时导入日志数据或流式数据到Hive中,可以使用Apache Flume。Flume是一个分布式、可靠的、高可扩展的日志收集工具,可以将数据源(如日志文件、消息队列)中的数据实时导入到Hive表中。

3、从本地文件系统中导入数据到Hive表;从HDFS上导入数据到Hive表;在创建表的时候通过从别的表中查询出相应的记录并插入到所创建的表中。

4、将存放在excel表中的数据如何导入到hive中,首先前提是excel表中数据类型以及长度要和hive仓库中表的字段属性一致,否则会报异常。

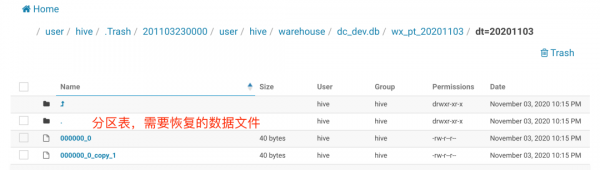

Hive插入多个分区时OOM故障解决记录

1、Fayson 在前两天给人调一个使用 Hive SQL 插入动态分区的 Parquet 表时,总是报错 OOM,也是折腾了很久。以下我们来看看整个过程。

2、多分区插入,方便实用,但是有时候会忘记语法,网上搜到很多坑(故意留坑的还挺多的),特此记录。

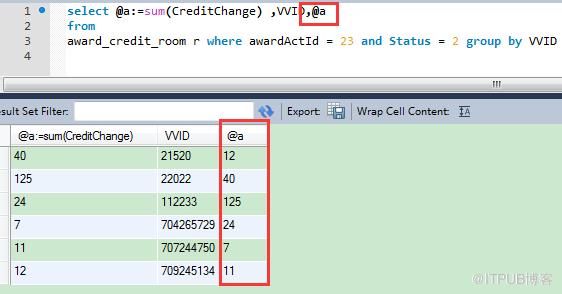

3、向分区表之中插入数据的时候,根据数据的某个字段的值,来创建分区,以及决定数据被插入到哪一个分区之中。

4、hive如果有过多的分区,由于底层是存储在HDFS上,HDFS上只用于存储大文件 而非小文件,因为过多的分区会增加namenode的负担。hive会转化为mapreduce,mapreduce会转化为多个task。

5、假设需要检索所有在2017年加入,查询搜索整个表所需的信息员工的详细信息。但是,如果用年份分区雇员数据并将其存储在一个单独的文件,它减少了查询处理时间。

6、在开发过程中使用spark去读取hive分区表的过程中(或者使用hive on spark、nodepad开发工具),部分开发人员未注意添加分区属性过滤导致在执行过程中加载了全量数据,引起任务执行效率低、磁盘IO大量损耗等问题。

jdbc连hive怎么批量插入

JDBC连接的方式,当然还有其他的连接方式,比如ODBC等, 这种方式很常用,可以在网上随便找到,就不再累赘了。不稳定,经常会被大数据量冲挂,不建议使用。

插入多少条,跟服务器硬件,JVM的配置,数据库的配置有关系。一般设置1000、500的就可以了。

我们可以使用addBatch()和executeBatch()方法选择标准的JDBC批处理,或者通过利用PreparedStatement对象的setExecuteBatch()方法和标准的executeUpdate()方法选择速度更快的Oracle专有的方法。

一列为id,一列为name。那么你的sql语句就可以写成insert into student values (student_seq .nextval, ?); 也就是说你用jdbcTemplate只需要设置name的值就行了,id是通过调用序列来插入的(即交给oracle解决)。

spring JdbcTemplate批量插入主键自动增长的方法:批量插入并返回批量id的方法需要改写返回值:注:由于JDBCTemplate不支持批量插入后返回批量id,所以此处使用jdbc原生的方法实现此功能。

mysql同步数据到hive大部分公司目前都是走的jdbc的方式。这种方式有两个好处:也有不好的地方:这一步最主要的细节是将mysql库的所有binlog数据全部打入一个kafka topic,格式使用json。

到此,以上就是小编对于hive 批量删除表的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏