本篇目录:

hive支持频繁数据更新

不是。Hive 的执行延迟比较高,因此 Hive 常用于数据分析,对实时性要求不高的场合。

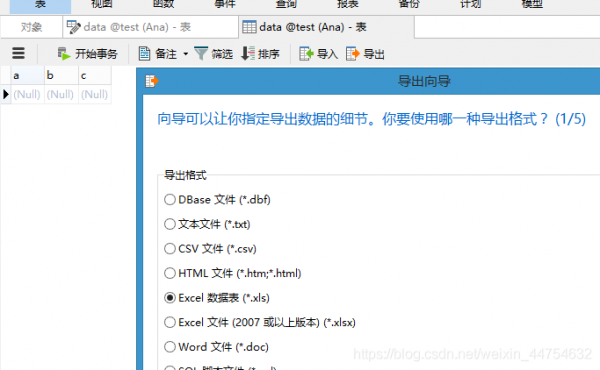

要想使用Hive首先需要启动hadoop,因为hive的使用是依赖于hadoop的hdfs文件系统以及MapReduce计算的,下图是启动hadoop,如下图。

数据更新:hive不支持数据更新,只可以读,不可以写,而sql支持数据更新;索引:hive没有索引,因此查询数据的时候是通过mapreduce很暴力的把数据都查询一遍,也造成了hive查询数据速度很慢的原因,而mysql有索引。

而sql支持数据更新。其次,Hive 中所有的数据都存储在 HDFS 中,Hive 中包含以下数据模型:表(Table),外部表(External Table),分区(Partition),桶(Bucket)。

hive支持update吗

1、自hive 0.11版本之后,hive也尝试在测试环境允许进行update和delte操作,但这些操作还不成熟,不敢在生产环境放心使用,其中也有一样不足。

2、要想使用Hive首先需要启动hadoop,因为hive的使用是依赖于hadoop的hdfs文件系统以及MapReduce计算的,下图是启动hadoop,如下图。

3、Hive 的目标是做成资料仓库,所以它提供了SQL,提供了档案-表的对映关系,又由于Hive基于HDFS,所以不提供Update,因为HDFS本身就不支援。

4、。Hive 的目标是做成数据仓库,所以它提供了SQL,提供了文件-表的映射关系,又由于Hive基于HDFS,所以不提供Update,因为HDFS本身就不支持。

5、hive.compactor.worker.threads – a positive 同样在建表后面添加: stored as orc TBLPROPERTIES(transactional=true); 以支持ACID的要求。

6、没有hudi这个单词,只有hive是正确单词,所以不存在区别。重点词汇:hive 英[hav]释义:n.忙碌的场所,繁忙的地方;蜂房,蜂箱;蜂群;蜂窝状物体。v.(蜜蜂)入蜂箱。

hive优化方法

1、join连接时的优化:当三个或多个以上的表进行join操作时,如果每个on使用相同的字段连接时只会产生一个mapreduce。join连接时的优化:当多个表进行查询时,从左到右表的大小顺序应该是从小到大。

2、压缩job的中间结果数据和输出数据,可以少量CPU时间节省出很多空间。

3、可以通过设置属性hive.exec.mode.local.auto的值为true,来让Hive在适当的时候自动启动这个优化,也可以将这个配置写在$HOME/.hiverc文件中。

4、对 Hive 的调优既包含对HiveSQL 语句本身的优化,也包含 Hive 配置项和 MR 方面的调整。列裁剪就是在查询时只读取需要的列。

到此,以上就是小编对于hive update delete的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏